Open WebUI - homedomotique -

Menu principal

- Page d'accueil

- Serveur

- Home assistant

- Integration HM

- Test produits

- Arduino

- ESP32

- Cours

- Solaire

- Téléchargement

Open WebUI

Open WebUI : l'interface Web du LLM

Introduction

Open WebUI, anciennement connu sous le nom d'Ollama WebUI, est une interface Web auto-

Open WebUI fournit une interface de type ChatGPT, permettant aux utilisateurs de discuter avec des serveurs distants exécutant des modèles de langage. Cette interface utilisateur Web est particulièrement utile pour ceux qui souhaitent exécuter des modèles de langage localement ou dans un environnement auto-

Extensibilité et fonctionnalités

Open WebUI a été conçu dans un souci d'extensibilité. Il prend en charge plusieurs exécuteurs LLM, ce qui signifie qu'il peut être configuré pour fonctionner avec différents modèles et frameworks de langage. Cette flexibilité permet aux utilisateurs de choisir le meilleur modèle pour leurs besoins spécifiques. L'interface utilisateur Web est conçue pour être conviviale, avec une interface claire qui facilite l'interaction avec les modèles.

Fonctionnement auto-

L'une des principales caractéristiques d'Open WebUI est sa capacité à fonctionner entièrement hors ligne. Cela est particulièrement important pour les utilisateurs soucieux de la confidentialité et de la sécurité des données. En exécutant l'interface utilisateur Web localement, les utilisateurs peuvent s'assurer que leurs données ne sont pas envoyées à des serveurs externes. Cette approche auto-

Open WebUI est un projet communautaire, ce qui signifie qu'il bénéficie des contributions et des commentaires d'un groupe diversifié d'utilisateurs et de développeurs. Cette approche collaborative permet de garantir que l'interface utilisateur Web continue d'évoluer et de s'améliorer au fil du temps, en intégrant de nouvelles fonctionnalités et en résolvant les problèmes qui surviennent.

Usage

Installation et configuration

Pour commencer à utiliser Open WebUI, les utilisateurs doivent installer le logiciel nécessaire et configurer leur environnement. Le processus d'installation implique généralement la configuration de Docker, car Open WebUI s'exécute dans un conteneur Docker. Cela garantit que l'interface utilisateur Web est isolée du système hôte et peut être facilement gérée.

Installer Docker : assurez-

Open WebUI fournit une interface de type ChatGPT, permettant aux utilisateurs de discuter avec des serveurs distants exécutant des modèles de langage. Cette interface utilisateur Web est particulièrement utile pour ceux qui souhaitent exécuter des modèles de langage localement ou dans un environnement auto-

Lancer Open WebUI : utilisez les commandes Docker pour extraire l'image Open WebUI et démarrer le conteneur (instructions ci-

# Si Ollama est sur votre ordinateur, utilisez cette commande :

docker run -

# Si Ollama est sur un autre serveur, utilisez cette commande :

# Pour vous connecter à Ollama sur un autre serveur, remplacez OLLAMA_BASE_URL par l'URL du serveur :

docker run -

docker run -

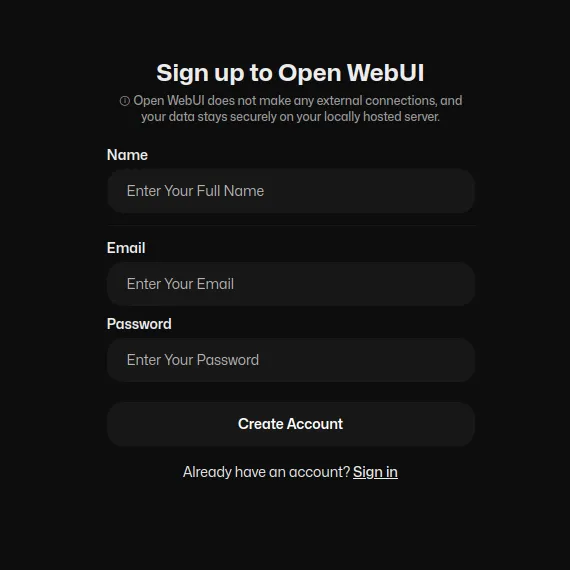

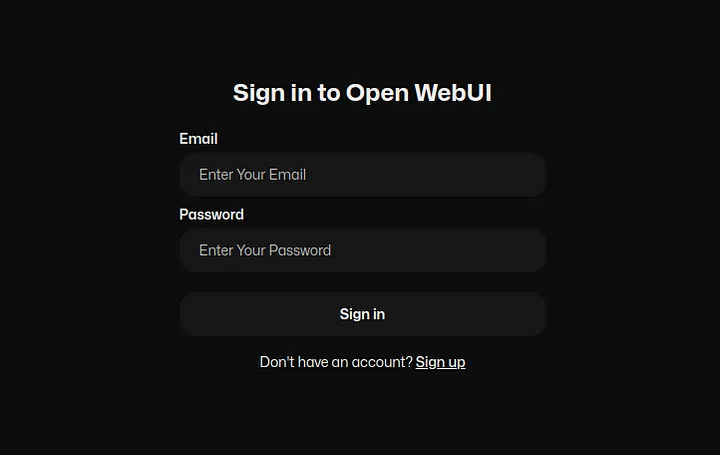

Créer un compte administrateur : le premier utilisateur à s'inscrire sur Open WebUI bénéficiera de privilèges d'administrateur. Ce compte disposera d'un contrôle complet sur l'interface utilisateur Web, y compris la possibilité de gérer d'autres utilisateurs et de configurer les paramètres.

Inscription à Open WebUI

Connexion aux modèles de langage

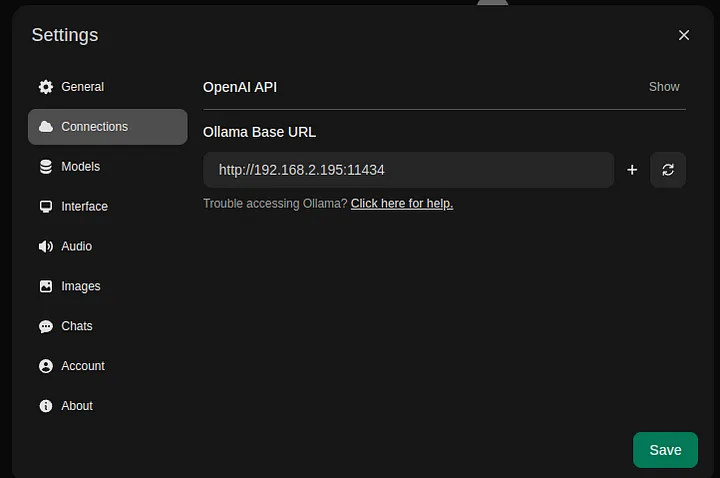

Une fois Open WebUI opérationnel, les utilisateurs peuvent le connecter à différents modèles de langage. Cela implique de configurer l'interface utilisateur Web pour communiquer avec les serveurs exécutant les modèles.

Configurer Ollama : Configurez vos instances Ollama auxquelles Open WebUI se connectera. Cela peut impliquer de spécifier les adresses de serveur.

Ouvrir les paramètres de l'interface Web

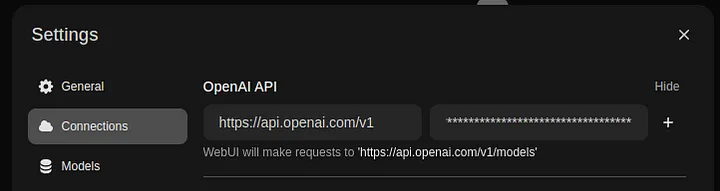

Configurer OpenAI (facultatif) : définissez la clé API OpenAI. Cela permet à Open WebUI de se connecter directement à OpenAI.

Ouvrir les paramètres de l'interface Web

Démo

Pour démontrer les capacités d'Open WebUI, examinons un exemple simple de configuration et d'utilisation de l'interface utilisateur Web pour interagir avec un modèle de langage.

Accéder à l'interface utilisateur Web : ouvrez un navigateur Web et accédez à l'adresse où Open WebUI est exécuté. Vous serez invité à créer un compte administrateur si c'est la première fois que vous accédez à l'interface utilisateur Web.

Ouvrir la connexion à l'interface Web

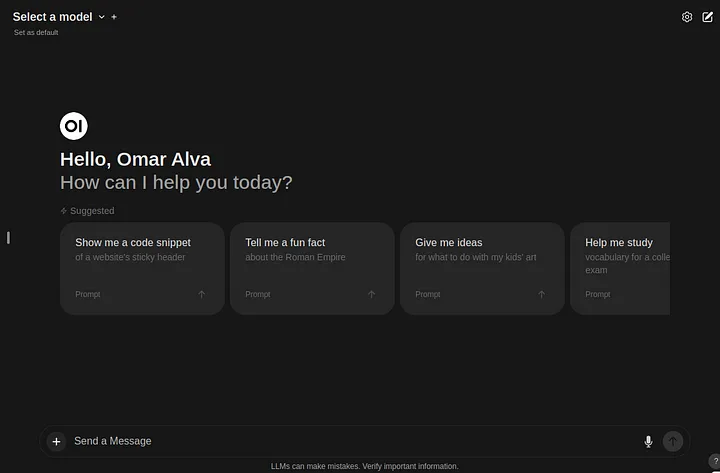

Démarrer une session de chat : Une fois connecté, vous pouvez démarrer une session de chat avec le modèle de langage. L'interface est conçue pour être intuitive, avec un champ de saisie de texte pour saisir vos requêtes et une fenêtre de chat pour afficher les réponses du modèle.

Page d'accueil de l'interface Web ouverte

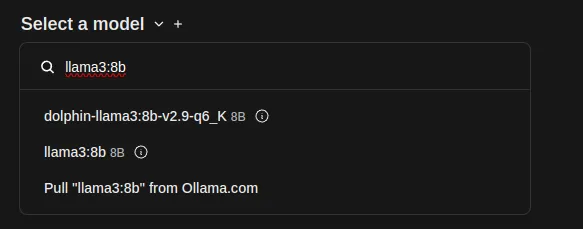

Ouvrir l'interface Web Sélectionner un modèle

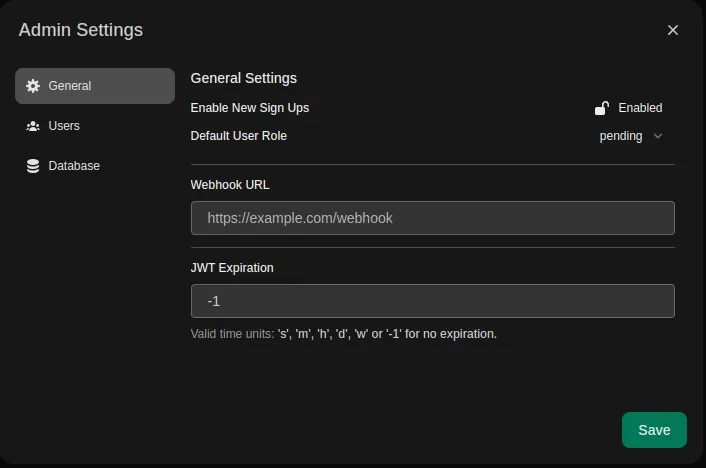

Gérer les paramètres : en tant qu'administrateur, vous avez accès à divers paramètres et configurations. Vous pouvez ajouter ou supprimer des instances de modèle, ajuster les paramètres d'équilibrage de charge et gérer les comptes d'utilisateurs.

Ouvrir les paramètres d'administration de l'interface Web

Conclusion

Open WebUI, l'interface utilisateur Web d'Ollama, est un outil puissant et flexible permettant d'interagir avec des modèles de langage dans un environnement auto-

Que vous soyez chercheur, développeur ou passionné, Open WebUI fournit les outils dont vous avez besoin pour exploiter la puissance des modèles de langage de manière sécurisée et efficace. Grâce à son développement axé sur la communauté et à ses fonctionnalités robustes, Open WebUI est sur le point de devenir une solution de premier plan pour les interfaces de modèles de langage auto-

____________________________

Haut de page